Evasion-Attacks auf LLMs

Künstliche Intelligenz ist längst kein Experiment mehr. Sprachmodelle steuern Chatbots, analysieren Verträge, generieren Code, verfassen Mails oder greifen auf interne Wissensdatenbanken zu. Was nach Effizienzgewinn klingt, bringt jedoch eine neue Risikoklasse mit sich: Evasion-Attacks auf LLMs.

Das Bundesamt für Sicherheit in der Informationstechnik warnt in einer aktuellen Veröffentlichung ausdrücklich vor gezielten Manipulationen von Sprachmodellen im laufenden Betrieb . Für Leitungsfunktionen bedeutet das: KI-Sicherheit ist nicht nur ein IT-Thema. Sie ist ein Governance-Thema.

Was steckt hinter Evasion-Attacks?

Anders als klassische Cyberangriffe verändern diese Attacken nicht den Quellcode oder die Modellparameter. Stattdessen manipulieren sie Eingaben so, dass das System seine eigenen Schutzmechanismen umgeht.

Mögliche Folgen:

Offenlegung sensibler Unternehmensdaten

Manipulation automatisierter Prozesse

Erzeugung rechtswidriger Inhalte

Reputationsschäden

Haftungsrisiken

Das Gefährliche: Das System funktioniert scheinbar normal – bis es plötzlich Dinge tut, die es laut Vorgaben niemals hätte tun dürfen .

LLMs, wo sind sie zu finden?

LLMs (Large Language Model) , also KI-Modelle, die Sprache verstehen und Texte erzeugen können, sind mittlerweile in nahezu jedem Unternehmen zu finden.

Beispiele: ChatGPT, Claude, Gemini, Copilot, Mistral etc.

LLMs sind zunehmend auch als Zusatzfunktionen in Fachanwendungen implementiert, Beispiele:

ERP- und CRM-Systeme

interne Dokumentenablagen

Entwicklerplattformen

Compliance-Workflows

Kundenkommunikation

Die eingebetteten KI-Funktionalitäten erhalten Ihre Rechte zumeist durch die Rechte, die auch die Anwendung hat. Je mehr Zugriff ein System erhält, desto größer wird die Angriffsfläche. Besonders riskant sind laut BSI Konstellationen mit:

Zugriff auf private Daten

Anbindung an externe Quellen

automatisierten Schreib- oder Versandfunktionen

DSGVO: Wenn das LLM zum Datenschutzproblem wird

Für Geschäftsführung und Datenschutzbeauftragte stellt sich eine zentrale Frage: Was passiert, wenn ein Sprachmodell personenbezogene Daten ungewollt preisgibt?

Typische Szenarien:

Ein Prompt Injection-Angriff führt zur Offenlegung von Kundendaten

Ein Modell speichert manipulierte Inhalte dauerhaft im Langzeitspeicher

Sensible Informationen werden über externe Schnittstellen übertragen

Ein kompromittiertes LLM-System kann meldepflichtige Datenschutzverletzungen auslösen – inklusive Bußgeld- und Reputationsrisiko.

Leitungsorgane stehen hier in der Organisationsverantwortung. Es reicht nicht, „KI einzuführen“, sie muss auch sicher implementiert sein.

AI Act: KI-Risiken werden regulatorisch relevant

Der AI-Act gibt die Regeln für den Einsatz von KI-Systemen konkret vor. In Verbindung mit der DSGVO sind die einzusetzenden Systeme VOR dem Einsatz zu prüfen, vgl. Art. 32, Art. 35 DSGVO. Aus der Prüfung ergibt sich eine unternehmensweite Richtlinie für die Nutzung von KI in dem jeweiligen Unternehmen. Gemäß Art. 4 AI-Act sind die Nutzer zudem vor der ersten Verwendung zu schulen.

Zusammenfassung aus DSGVO und AI-Act:

Unabhängig davon, in welche Kategorie des AI-Actes ein LLM-System eingestuft wird, gelten bestimmte Pflichten immer.

DSGVO: Vorabkontrolle

Die datenschutzrechtliche Vorabkontrolle, dient zur Identifikation möglicher Risiken für personenbezogene Daten.

Art. 24 DSGVO – Organisationsverantwortung

Art. 32 DSGVO – technische und organisatorische Maßnahmen

Art. 35 DSGVO – Datenschutz-Folgenabschätzung (wenn hohes Risiko)

Aus der Vorabkontrolle folgt eine Empfehlung des bDSB, wie mit KI und personenbezogenen Daten umgegangen werden soll und ob personenbezogene Daten überhaupt genutzt werden können.

Daraus folgt in Abstimmung mit den Leitungsfunktionen die Erstellung einer internen KI-Richtlinie.

In diese Richtlinie gehört mindestens eine Aufzählung der genutzten Systeme und die klare Benennung von Do’s & Dont’s in dem jeweiligen System.

Art. 4 AI Act – KI-Kompetenzpflicht (gilt für alle KI-Systeme)

Unternehmen müssen sicherstellen, dass Personen, die KI-Systeme einsetzen oder überwachen, über ausreichende Kenntnisse verfügen und unter welchen Einschränkungen KI im Hause genutzt werden darf.

Die Grundlage der Nutzung ergibt sich aus der Richtlinie und genau diese Inhalte werden geschult.

Das bedeutet:

- Unterweisung der Mitarbeiter

Sensibilisierung für Risiken wie Prompt Injections

Das ist eine Organisationspflicht und kein nice to have.

Art. 50 AI Act – Transparenzpflichten (gelten unabhängig von der Risikoklasse)

Wenn KI eingesetzt wird, müssen bestimmte Transparenzanforderungen erfüllt sein, zum Beispiel:

Kennzeichnung von KI-generierten Inhalten

Offenlegung gegenüber Nutzern, wenn sie mit KI interagieren, z.B. bei ChatBots

Klarheit über synthetische Inhalte

Auch hier gilt: Das betrifft alle KI-Systeme unabhängig der Klassifizierung.

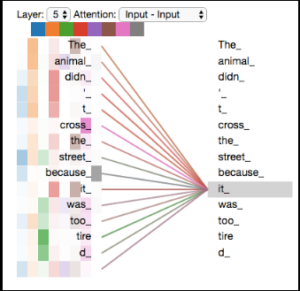

Typische Angriffsformen auf LLMs

Das BSI beschreibt unter anderem die folgenden Angriffsvarianten.

Verantwortung von Führungskräften

KI-Risikobewertung auf Managementebene verankern

Ist das eingesetzte LLM an interne Daten angebunden?

Was sagt der Datenschutz?

Welche Aktionen darf es autonom ausführen?

Gibt es eine dokumentierte Risikoanalyse?

Least Privilege konsequent umsetzen

LLM-Systeme dürfen nur Zugriff auf Daten und Funktionen erhalten, die zwingend notwendig sind. Jede zusätzliche Berechtigung erhöht das Angriffsrisiko .

Serverseitige Schutzmechanismen etablieren

Das BSI empfiehlt unter anderem:

Eingabenormalisierung

Längenbeschränkungen

Content-Stripping

Filter für schädliche Prompts

Schwärzung sensibler Informationen

Wichtig: Clientseitige Filter sind nicht ausreichend.

Menschliche Aufsicht implementieren

Der AI Act verlangt menschliche Kontrolle bei KI-Systemen der Kategorie „hochrisiko“. Das BSI bestätigt diesen Ansatz durch sogenannte Human Guardrails und dies nutzungs- und nicht KI-kategoriebezogen.

Beispiel:

Kritische Aktionen wie E-Mail-Versand oder Datenexport müssen aktiv freigegeben werden.

Fazit

KI-Cybersicherheit ist kein reines IT-Detail, sondern mittlerweile ein Standard-Arbeitspaket im Kontext IT-Sicherheit und Datenschutz. Führungskräfte müssen die Grundmechanismen verstehen, um Risiken realistisch bewerten zu können .

Die „KI-Welt“ ist schnellebig, es sollte bei Updates von Systemen genau geprüft werden, ob eine KI-Funktionalität inkludiert oder erweitert wurde und was dies für die Nutzung im Unternehmen bedeutet.

Bei der Bewertung müssen unterschiedlichste Normen mit einbezogen werden, neben dem AI-Act auch die DSGVO, ggf. NIS 2 (Also BSIG), Geschäftsgeheimnisgesetz, ggf. Urheberrecht etc.

Wenn Sie jetzt noch unsicher sind, in Bezug auf die Nutzung von KI-Systemen oder eine Richtlinie erstellen lassen möchten und/oder Ihre Mitarbeiter kompetent schulen lassen möchten, dann sprechen Sie mich an, ich unterstütze Sie in allen Fragen rund um das Thema KI.